НАИЛУЧШЕЕ ПРИБЛИЖЕНИЕ, важное понятие теории приближения

функций. Пусть f(x) - произвольная непрерывная функция, заданная на

нек-ром отрезке [а, b], a  1(x),

1(x),  2 (x), . . .,

2 (x), . . .,  n(x) -

фиксированная система непрерывных функций на том же отрезке. Тогда максимум

выражения:

n(x) -

фиксированная система непрерывных функций на том же отрезке. Тогда максимум

выражения:

|f(x)-a1 1(x)-a2

1(x)-a2 2(x)-...-an

2(x)-...-an n(x)| (*)

на отрезке [а, b] наз. уклонением функции f (х) от полинома

Рп(х) = a1

n(x)| (*)

на отрезке [а, b] наз. уклонением функции f (х) от полинома

Рп(х) = a1 1(x)+a2

1(x)+a2 2(x)+...+an

2(x)+...+an n(x), а минимум уклонения для всевозможных

полиномов Pn (х) (т. е. при всевозможных наборах

коэффициентов a1, a2,..., a3) - наилучшим

приближением функции f(x) посредством системы

n(x), а минимум уклонения для всевозможных

полиномов Pn (х) (т. е. при всевозможных наборах

коэффициентов a1, a2,..., a3) - наилучшим

приближением функции f(x) посредством системы  1(x),

1(x),  2(x),...,

2(x),...,  n(x),

H. п. обозначают через En(f,

n(x),

H. п. обозначают через En(f,  ). Таким образом, H. п.

является минимумом максимума или, как говорят, минимаксом.

). Таким образом, H. п.

является минимумом максимума или, как говорят, минимаксом.

Полином P*n

(х, f), для к-рого уклонение от функции f(x) равно H. п. (такой

полином всегда существует), наз. полиномом, наименее уклоняющимся от функции f(x)

(на отрезке [а, b]).

Понятия H. п. и полинома,

наименее уклоняющегося от функции f(x), были впервые введены П. Л. Чебышевым

(1854) в связи с исследованиями по теории механизмов. Можно также рассматривать

H. п., когда под уклонением функции f(x) от полинома Рп(х)

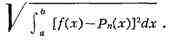

понимается не максимум выражения (*), а, напр.,

См. Приближение и

интерполирование функций.

НАИМЕНЬШЕГО ДЕЙСТВИЯ

ПРИНЦИП, один из вариационных

принципов механики, согласно к-рому для данного класса сравниваемых друг с

другом движений механич. системы действительным является то, для к-рого физ.

величина, наз. действием, имеет минимум (точнее, экстремум). Обычно H.

д. п. применяется в одной из двух форм.

а) H. д. п. в форме

Гамильтона - Остроградского устанавливает, что среди всех кинематически

возможных перемещений системы из одной конфигурации в другую (близкую к

первой), совершаемых за один и тот же промежуток времени, действительным

является то, для к-рого действие по Гамильтону S будет наименьшим. Математич.

выражение H. д. п. имеет в этом случае вид:  S = О, где

S = О, где  - символ неполной

(изохронной) вариации.

- символ неполной

(изохронной) вариации.

б) H. д. п. в форме Мопертюи

- JIaгранжа устанавливает, что среди всех кинематически возможных перемещений

системы из одной конфигурации в близкую к ней другую, совершаемых при

сохранении одной и той же величины полной энергии системы, действительным

является то, для к-рого действие по JIaгранжу W будет наименьшим. Математич.

выражение H. д. п. в этом случае имеет вид  W = О, где

W = О, где  - символ полной

вариации (в отличие от принципа Гамильтона - Остроградского, здесь варьируются

не только координаты и скорости, но и время перемещения системы из одной

конфигурации в другую). H. д. п. в этом случае справедлив только для

консервативных и притом голономных систем, в то время как в первом случае H. д.

п. является более общим и, в частности, может быть распространён на

неконсервативные системы. H. д. п. пользуются для составления ур-ний движения

механич. систем и для исследования общих свойств этих движений. При

соответствующем обобщении понятий H. д. п. находит приложения в механике

непрерывной среды, в электродинамике, квантовой механике и др.

- символ полной

вариации (в отличие от принципа Гамильтона - Остроградского, здесь варьируются

не только координаты и скорости, но и время перемещения системы из одной

конфигурации в другую). H. д. п. в этом случае справедлив только для

консервативных и притом голономных систем, в то время как в первом случае H. д.

п. является более общим и, в частности, может быть распространён на

неконсервативные системы. H. д. п. пользуются для составления ур-ний движения

механич. систем и для исследования общих свойств этих движений. При

соответствующем обобщении понятий H. д. п. находит приложения в механике

непрерывной среды, в электродинамике, квантовой механике и др.

Лит. см. при ст. Вариационные принципы

механики.

С. M. Тарг.

НАИМЕНЬШЕГО ПРИНУЖДЕНИЯ

ПРИНЦИП, то же, что Гаусса

принцип.

НАИМЕНЬШЕЕ ОБЩЕЕ КРАТНОЕ,

двух или нескольких

натуральных чисел - наименьшее, делящееся на каждое из них, положительное

число. Напр., H. о. к. чисел 2 и 3 есть 6, чисел 6, 8, 9, 15 и 20 есть 360. H.

о. к. пользуются при сложении и вычитании дробей: наименьшим общим знаменателем

двух или нескольких дробей является H. о. к. их знаменателей. Если известны

разложения заданных чисел на простые множители, то для получения H. о. к. этих

чисел нужно составить произведение всех множителей, взяв каждый наибольшее

число раз, какое он встречается. Так, 6 = 23, 8 = 222, 9

= 33, 15 = 3*5 и 20 = 22*5; поэтому H. о. к. 6, 8, 9, 15

и 20 есть 22233*5 = 360. Понятие H. о. к. применимо не только к

числам. Так, напр., H. о. к. двух или нескольких многочленов есть многочлен

наинизшей степени, делящийся на каждый из данных. См. также Наибольший

общий делитель.

НАИМЕНЬШЕЙ КРИВИЗНЫ

ПРИНЦИП, то же, что Герца

принцип.

НАИМЕНЬШИХ КВАДРАТОВ

МЕТОД, один из

методов ошибок теории для оценки неизвестных величин по результатам

измерений, содержащим случайные ошибки. H. к. м. применяется также для

приближённого представления заданной функции другими (более простыми) функциями

и часто оказывается полезным при наблюдений обработке. H. к. м.

предложен К. Гауссом (1794-95) и А. Лежандром (1805-06).

Первоначально H. к. м. использовался для обработки результатов астрономич. и

геодезич. наблюдений. Строгое матем. обоснование и установление границ

содержательной применимости H. к. м. даны А. А. Марковым (старшим) и A.

H. Колмогоровым. Ныне H. к. м. представляет собой один из важнейших

разделов матем. статистики и широко используется для статистич. выводов в

различных областях науки и техники.

Сущность обоснования H. к.

м. (по Гауссу) заключается в допущении, что "убыток" от замены

точного (неизвестного) значения физ. величины  её приближённым значением X, вычисленным

по результатам наблюдений, пропорционален квадрату ошибки: (X -

её приближённым значением X, вычисленным

по результатам наблюдений, пропорционален квадрату ошибки: (X -  )2. В

этих условиях оптимальной оценкой естественно признать такую лишённую

систематич. ошибки величину X, для к-рой среднее значение

"убытка" минимально. Именно это требование и составляет основу H. к.

м. В общем случае отыскание оптимальной в смысле H. к. м. оценки X - задача

весьма сложная, поэтому практически эту задачу сужают и в качестве X выбирают

линейную функцию от результатов наблюдений, лишённую систематич. ошибки, и

такую, для к-рой среднее значение "убытка" минимально в классе всех

линейных функций. Если случайные ошибки наблюдений подчиняются нормальному

распределению и оцениваемая величина

)2. В

этих условиях оптимальной оценкой естественно признать такую лишённую

систематич. ошибки величину X, для к-рой среднее значение

"убытка" минимально. Именно это требование и составляет основу H. к.

м. В общем случае отыскание оптимальной в смысле H. к. м. оценки X - задача

весьма сложная, поэтому практически эту задачу сужают и в качестве X выбирают

линейную функцию от результатов наблюдений, лишённую систематич. ошибки, и

такую, для к-рой среднее значение "убытка" минимально в классе всех

линейных функций. Если случайные ошибки наблюдений подчиняются нормальному

распределению и оцениваемая величина  зависит от средних значений

результатов наблюдений линейно (случай, весьма часто встречающийся в

приложениях H. к. м.), то решение этой задачи будет одновременно являться и

решением общей задачи. При этом оптимальная оценка X также подчиняется

нормальному распределению со средним значением

зависит от средних значений

результатов наблюдений линейно (случай, весьма часто встречающийся в

приложениях H. к. м.), то решение этой задачи будет одновременно являться и

решением общей задачи. При этом оптимальная оценка X также подчиняется

нормальному распределению со средним значением  и, следовательно, плотность

вероятности случайной величины X

и, следовательно, плотность

вероятности случайной величины X  (х;

(х;  ,

,  ) = (1/SQR(2

) = (1/SQR(2 )

) )

)

(-[(x-

(-[(x- )/

)/ ]2/2) при х=Х достигает максимума в

точке

]2/2) при х=Х достигает максимума в

точке  =

X (это свойство и выражает точное содержание распространённого в теории

ошибок утверждения "оценка X, вычисленная согласно H. к. м.,-

наиболее вероятное значение неизвестного параметра

=

X (это свойство и выражает точное содержание распространённого в теории

ошибок утверждения "оценка X, вычисленная согласно H. к. м.,-

наиболее вероятное значение неизвестного параметра  ).

).

Случай одного неизвестного.

Пусть для оценки значения неизвестной величины  произведено n независимых

наблюдений, давших результаты Y1, Y2,..., Yn,

т. е. Y1=

произведено n независимых

наблюдений, давших результаты Y1, Y2,..., Yn,

т. е. Y1= +

+ 1, Y2 =

1, Y2 =  +

+  2,..., Yn=

2,..., Yn= +

+ n, где

n, где  1,

1,  2,...,

2,..., n -

случайные ошибки (по определению, принятому в классической теории ошибок,

случайные ошибки - независимые случайные величины с нулевым математическим

ожиданием: Е

n -

случайные ошибки (по определению, принятому в классической теории ошибок,

случайные ошибки - независимые случайные величины с нулевым математическим

ожиданием: Е i = 0; если же Е

i = 0; если же Е i<>0, то Е

i<>0, то Е i

наз. систематическими ошибками). Согласно H. к. м., в качестве оценки

величины

i

наз. систематическими ошибками). Согласно H. к. м., в качестве оценки

величины  принимают такое X, для к-рого будет наименьшей сумма

квадратов (отсюда и само название метода):

принимают такое X, для к-рого будет наименьшей сумма

квадратов (отсюда и само название метода):

(коэффициент k > 0

можно выбирать произвольно). Величину pi наз. весом, а  i

- квадратичным отклонением измерения с номером i. В частности, если

все измерения равноточны, то

i

- квадратичным отклонением измерения с номером i. В частности, если

все измерения равноточны, то  1 =

1 =  2 = ... =

2 = ... = n, и в

этом случае можно положить

n, и в

этом случае можно положить  1 =

1 =  2 =...=

2 =...=  п = 1; если же

каждое Yi - арифметич. среднее из niравноточных

измерений, то полагают

п = 1; если же

каждое Yi - арифметич. среднее из niравноточных

измерений, то полагают  i = ni.

i = ni.

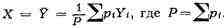

Сумма S (X) будет

наименьшей, если в качестве X выбрать взвешенное среднее:

Оценка Y величины  лишена

систематич. ошибки, имеет вес P и дисперсию DY = k/Р. В частности, если

все измерения равноточны, то Y - арифметич. среднее результатов измерений:

лишена

систематич. ошибки, имеет вес P и дисперсию DY = k/Р. В частности, если

все измерения равноточны, то Y - арифметич. среднее результатов измерений:

При нек-рых общих

предположениях можно показать, что если количество наблюдений n достаточно

велико, то распределение оценки Y мало отличается от нормального с математич.

ожиданием  и дисперсией k/P. B этом случае абс. погрешность

приближённого равенства

и дисперсией k/P. B этом случае абс. погрешность

приближённого равенства

= Y меньше t SQR(k/P) с

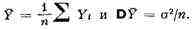

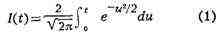

вероятностью, близкой к значению интеграла

= Y меньше t SQR(k/P) с

вероятностью, близкой к значению интеграла

[напр.,

I (1,96) = 0,950; I (2,58) = 0,990; I (3,00) = 0,997].

Если веса измерений  i заданы, а

множитель k до наблюдений остаётся неопределённым, то этот множитель и

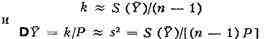

дисперсия оценки Y могут быть приближённо оценены по формулам:

i заданы, а

множитель k до наблюдений остаётся неопределённым, то этот множитель и

дисперсия оценки Y могут быть приближённо оценены по формулам:

(обе оценки лишены

систематич. ошибок). В том практически важном случае, когда ошибки  , подчиняются

нормальному распределению, можно найти точное значение вероятности, с к-рой

абс. погрешность приближённого равенства

, подчиняются

нормальному распределению, можно найти точное значение вероятности, с к-рой

абс. погрешность приближённого равенства ~ Y окажется меньше ts (t -

произвольное положительное число). Эту вероятность, как функцию от t, наз.

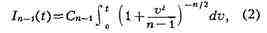

функцией распределения Стьюдента с n - 1 степенями свободы и вычисляют по

формуле:

~ Y окажется меньше ts (t -

произвольное положительное число). Эту вероятность, как функцию от t, наз.

функцией распределения Стьюдента с n - 1 степенями свободы и вычисляют по

формуле:

где постоянная Cn-1

выбрана таким образом, чтобы выполнялось условие: In-1 (oo)

= 1. При больших n формулу (2) можно заменить формулой (1). Однако

применение формулы (1) при небольших n привело бы к грубым ошибкам. Так,

напр., согласно (1), значению I = 0,99 соответствует t = 2,58; истинные

значения t, определяемые при малых n как решения соответствующих

уравнений In-1(t) = 0,99, приведены в таблице:

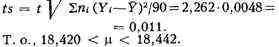

Пример. Для определения

массы нек-рого тела произведено 10 независимых равноточных взвешиваний, давших

результаты Yi (в г):

(здесь ni - число

случаев, в к-рых наблюдался вес Yi, причём n =  ni = 10).

Так как все взвешивания равноточные, то следует положить

ni = 10).

Так как все взвешивания равноточные, то следует положить  i = ni и

в качестве оценки для неизвестного веса

i = ni и

в качестве оценки для неизвестного веса  выбрать величину Y =

выбрать величину Y =  niYi/

niYi/ ni

= 18,431. Задавая, напр., I9 = 0,95, по таблицам

распределения Стьюдента с девятью степенями свободы можно найти, что t = 2,262,

и поэтому в качестве предельной абс. погрешности приближенного равенства

ni

= 18,431. Задавая, напр., I9 = 0,95, по таблицам

распределения Стьюдента с девятью степенями свободы можно найти, что t = 2,262,

и поэтому в качестве предельной абс. погрешности приближенного равенства  ~ 18,431

следует принять величину

~ 18,431

следует принять величину

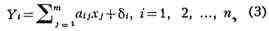

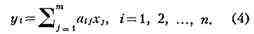

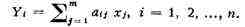

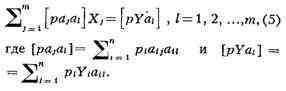

Случаи нескольких

неизвестных (линейные связи). Пусть n результатов измерений Y1,

Y2,..., Yn связаны с т неизвестными величинами x1,

x2,..., xm (т < п) независимыми линейными

отношениями

где аij - известные

коэффициенты, а  ? - независимые случайные ошибки измерений. Требуется

оценить неизвестные величины xj(эту задачу можно

рассматривать как обобщение предыдущей, в к-рой

? - независимые случайные ошибки измерений. Требуется

оценить неизвестные величины xj(эту задачу можно

рассматривать как обобщение предыдущей, в к-рой  = x1 и т = аi1

= 1; i = 1,2,...,п).

= x1 и т = аi1

= 1; i = 1,2,...,п).

Так как Е i= О, то

средние значения результатов измерений yi = EYiсвязаны

с неизвестными величинами x1, x2,..., xm линейными

уравнениями (линейные связи):

i= О, то

средние значения результатов измерений yi = EYiсвязаны

с неизвестными величинами x1, x2,..., xm линейными

уравнениями (линейные связи):

Следовательно, искомые

величины xjпредставляют собой решение системы (4), уравнения

к-рой предполагаются совместными. Точные значения измеряемых величин уi

и случайные ошибки  ? обычно неизвестны, поэтому

вместо систем (3) и (4) принято записывать т. н. условные уравнения

? обычно неизвестны, поэтому

вместо систем (3) и (4) принято записывать т. н. условные уравнения

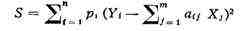

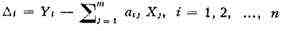

Согласно H. к. м., в

качестве оценок для неизвестных xj применяют такие величины xj,

для к-рых сумма квадратов отклонений

будет наименьшей (как и в

предыдущем случае, i - вес измерения Yi - величина,

обратно пропорциональная дисперсии случайной ошибки

i - вес измерения Yi - величина,

обратно пропорциональная дисперсии случайной ошибки  i).

Условные уравнения, как правило, несовместны, т. е. при любых значениях Xjразности

i).

Условные уравнения, как правило, несовместны, т. е. при любых значениях Xjразности

не могут, вообще говоря, все

обратиться в нуль, и в этом случае S =

i

i 2i

также не может обратиться в нуль. H. к. м. предписывает в качестве оценок

выбрать такие значения Xj, к-рые минимизируют сумму S. В тех

исключительных случаях, когда условные ур-ния совместны и, значит, обладают

решением, это решение совпадает с оценками, полученными согласно H. к. м.

2i

также не может обратиться в нуль. H. к. м. предписывает в качестве оценок

выбрать такие значения Xj, к-рые минимизируют сумму S. В тех

исключительных случаях, когда условные ур-ния совместны и, значит, обладают

решением, это решение совпадает с оценками, полученными согласно H. к. м.

Сумма квадратов S

представляет собой квадратичный многочлен относительно переменных Xj;

этот многочлен достигает минимума при таких значениях X1, X2,...,

Xm, при которых обращаются в нуль все первые частные

производные:

Отсюда следует, что оценки Xj,

полученные согласно H. к. м., должны удовлетворять системе т. н. нормальных

уравнений, к-рая в обозначениях, предложенных Гауссом, имеет вид:

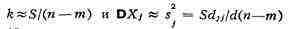

Оценки Xj, получающиеся

в результате решения системы нормальных уравнений, лишены систематич. ошибок (EXj

= xj); дисперсии DXj величин Xjравны

kdjj/d, где d - определитель системы (5), а djj

- минор, соответствующий диагональному элементу [ ajaj]

(иными словами, djj/d - вес оценки Xj). Если

множитель пропорциональности k (k наз. дисперсией на единицу веса)

заранее неизвестен, то для его оценки, а также для оценки дисперсии DX, служат

формулы: (S - минимальное значение исходной суммы квадратов). При

нек-рых общих

ajaj]

(иными словами, djj/d - вес оценки Xj). Если

множитель пропорциональности k (k наз. дисперсией на единицу веса)

заранее неизвестен, то для его оценки, а также для оценки дисперсии DX, служат

формулы: (S - минимальное значение исходной суммы квадратов). При

нек-рых общих

предположениях можно показать,

что если количество наблюдений n достаточно велико, то абс. погрешность

приближённого равенства xj ~ Xj меньше tsj с вероятностью,

близкой к значению интеграла (1). Если случайные ошибки наблюдении  ?

подчиняются нормальному распределению, то все отношения (Xj - xj)/sj

распределены по закону Стьюдента с n- т степенями свободы [точная

оценка абс. погрешности приближённого равенства производится здесь с помощью

интеграла (2) так же, как в случае одного неизвестного]. Кроме того,

минимальное значение суммы S в вероятностном смысле не зависит от X1, Х2,...,

Xm и поэтому приближённые значения дисперсий оценок DXj ~ s2j

?

подчиняются нормальному распределению, то все отношения (Xj - xj)/sj

распределены по закону Стьюдента с n- т степенями свободы [точная

оценка абс. погрешности приближённого равенства производится здесь с помощью

интеграла (2) так же, как в случае одного неизвестного]. Кроме того,

минимальное значение суммы S в вероятностном смысле не зависит от X1, Х2,...,

Xm и поэтому приближённые значения дисперсий оценок DXj ~ s2j

не зависят от самих оценок Xj.

Один из наиболее типичных случаев

применения H. к. м. - "выравнивание" таких результатов наблюдений Yi,

для к-рых в уравнениях (3) аij = aj (ti), где

aj (t) - известные функции нек-рого параметра t (если t - время,

то t1, t2,...- те моменты времени, в к-рые

производились наблюдения). Особенно часто встречается в приложениях случай т.

н. параболич. интерполяции, когда aj (t)- многочлены [напр., a1

(t) = 1, a2 (t) = t, а3 (t) = t2,

...и т. д.]; если t2 - t1 = t3 - t2

=...= tn - tn-1, a наблюдения равноточные, то для

вычисления оценок Xj можно воспользоваться таблицами

ортогональных многочленов, имеющимися во многих руководствах по современной

вычислительной математике. Другой важный для приложения случай - т. н.

гармонич. интерполяция, когда в качестве aj(t) выбирают

триго-нометрич. функции [напр., aj (t)= cos(j-1)t,j =

1,2,..., т].

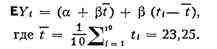

Пример. Для оценки точности

одного из методов хим. анализа этим методом определялась концентрация CaO в

десяти эталонных пробах заранее известного состава. Результаты равноточных

наблюдений указаны в таблице (i - номер эксперимента, ti - истинная

концентрация CaO, Ti - концентрация CaO, определённая в

результате химического анализа, Yi = Ti - ti

- ошибка химического анализа):

Если результаты хим. анализа

не имеют систематич. ошибок, то ЕYi = О. Если же такие ошибки

имеются, то в первом приближении их можно представить в виде: ЕYi

=  +

+  t?(

t?( наз.

постоянной ошибкой, а

наз.

постоянной ошибкой, а  t?- методич. ошибкой) или, что то

же самое,

t?- методич. ошибкой) или, что то

же самое,

Для отыскания оценок  и

и  достаточно

оценить коэффициенты х1=

достаточно

оценить коэффициенты х1=  +

+  t и x2 =

t и x2 =  . Условные

уравнения в данном случае имеют вид:

. Условные

уравнения в данном случае имеют вид:

Yi = x1 + x2 (ti

- t), ? =

1,2,..., 10, поэтому

ai1 = 1, ai2 = ti - t

(согласно предположению о равноточности наблюдений, все i = 1).

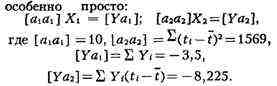

Так как [a1a2] = [a2ai]=

i = 1).

Так как [a1a2] = [a2ai]=  (ti

- t) =0, то система нормальных уравнений записывается

(ti

- t) =0, то система нормальных уравнений записывается

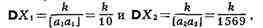

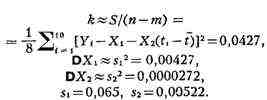

Дисперсии компонент решения

этой системы суть

где k - неизвестная

дисперсия на единицу веса (в данном случае k - дисперсия любой из

величин Yi). T. к. в этом примере компоненты решения

принимают значения X1 = - 0,35 и X2 = - 0,00524, то

Если случайные ошибки

наблюдений подчиняются нормальному распределению, то отношения |Xj

- xj|sj (j = 1,2) распределены по закону Стьюдента. В

частности, если результаты наблюдений лишены систематич. ошибок,  o x1

= x1=2 и значит закону Стьюдента должны подчиняться отношения |X1|/s1

и |X2|/s2. С помощью таблиц распределения Стьюдента с n

- т = 8 степенями свободы можно убедиться, что если действительно x1

= x2 = 0, то с вероятностью 0,999 каждое из этих

отношений не должно превосходить 5,04 и с вероятностью 0,95 не должно превосходить

2,31. В данном случае |X1|/s1 = 5,38 > 5,04, поэтому

гипотезу отсутствия систематич. ошибок целесообразно отвергнуть; в то же время

следует признать, что гипотеза об отсутствии методич. ошибки (x2

= О) не противоречит результатам наблюдений, так как |X2|/s2

= 1,004 < 2,31. T. о., можно заключит, что для определения t по результату

наблюдения T целесообразно пользоваться приближённой формулой t =

T + 0,35.

o x1

= x1=2 и значит закону Стьюдента должны подчиняться отношения |X1|/s1

и |X2|/s2. С помощью таблиц распределения Стьюдента с n

- т = 8 степенями свободы можно убедиться, что если действительно x1

= x2 = 0, то с вероятностью 0,999 каждое из этих

отношений не должно превосходить 5,04 и с вероятностью 0,95 не должно превосходить

2,31. В данном случае |X1|/s1 = 5,38 > 5,04, поэтому

гипотезу отсутствия систематич. ошибок целесообразно отвергнуть; в то же время

следует признать, что гипотеза об отсутствии методич. ошибки (x2

= О) не противоречит результатам наблюдений, так как |X2|/s2

= 1,004 < 2,31. T. о., можно заключит, что для определения t по результату

наблюдения T целесообразно пользоваться приближённой формулой t =

T + 0,35.

Во многих практически важных

случаях (и в частности, при оценке сложных нелинейных связей) количество

неизвестных параметров бывает весьма большим и поэтому реализация H. к. м.

оказывается эффективной лишь при использовании современной вычислительной

техники.

Лит.: Марков А. А., Исчисление

вероятностей, 4 изд., M., 1924; Колмогоров A. H., К обоснованию метода

наименьших квадратов, "Успехи математических наук", 1946, т. 1, в. 1;

Л и н н и к Ю. В., Метод наименьших квадратов и основы

математико-статистической теории обработки наблюдений, 2 изд., M., 1962;

Helmert F. R., Die Ausgleichungsrechnung nach der Methode der kleinsten

Quadrate..., 2 Aufl., Lpz., 1907.

Л. H. Большев.